Что такое robots.txt и зачем вообще нужен индексный файл

От robots.txt зависит, какие страницы сайта попадают в результаты поиска. Поэтому он крайне важен для SEO и банальной информационной безопасности. Что это за файл и как его использовать — читайте в нашем материале.

Содержание:

1. Что такое robots.txt

2. Зачем нужен индексный файл

3. Правила robots.txt

4. Примеры содержимого robots.txt

5. Как создать индексный файл

6. Заключение

Что такое robots.txt

Robots.txt, также известный как индексный файл, — это текстовый документ, который содержит правила сканирования сайта поисковыми системами. Эти инструкции дают Google и другим подобным сервисам понять, какие материалы веб-ресурса можно анализировать и добавлять в индекс, а какие нельзя. Владелец сайта может в любой момент создать такой файл и прописать необходимые ему правила. Тогда поисковики будут вынуждены их соблюдать.

Зачем нужен индексный файл

С помощью robots.txt можно блокировать доступ поисковых ботов к любым разделам сайта, веб-страницам и даже отдельным файлам, будь то изображения, аудио или видеоролики.

Таким образом можно предотвратить попадание этих материалов веб-ресурса в результаты поиска. Тогда их не увидят посторонние. Но есть нюанс. Если на страницу, сканирование которой вы запретили, имеются ссылки на других сайтах, она все равно может оказаться среди результатов поиска. Чтобы это предотвратить, нужно прописать в коде этой страницы правило «noindex».

Если же вы, наоборот, продвигаете сайт в поисковиках, но заметили, что или весь ресурс целиком или некоторые его страницы не попадают в выдачу, то в таких ситуациях нужно первым делом проверять robots.txt. Ведь в нем может быть прописан запрет на сканирование.

Правила robots.txt

Правила — или инструкции — сканирования сайта, которые можно добавлять в индексный файл, называются директивами. Давайте разберем главные из них.

Директива User-agent (обязательная)

Эта директива открывает группу правил и определяет, какие поисковые роботы должны выполнять все правила текущей группы. Синтаксис будет таким: «User-agent: название робота».

К примеру, если вы хотите создать группу правил для поискового робота Google, директиву нужно прописывать так:

Для робота Bing так:

Если же вы хотите создать универсальную группу правил сразу для всех поисковых систем, используйте вместо названия робота звездочку:

Директивы Disallow и Allow (обязательные)

Каждая группа правил должна содержать хотя бы одну из двух директив: Disallow или Allow.

Директива Disallow указывает на раздел сайта, страницу или файл, который запрещено сканировать текущему поисковому роботу. Синтаксис: «Disallow: путь к разделу/странице/файлу относительно корневой папки».

Например, чтобы запретить роботу сканировать страницу hidden-page.html из корневой папки, нужно добавить в robots.txt следующий текст:

А если вы захотите полностью запретить сканирование сайта, директиву нужно будет записать так:

Директива Allow указывает на раздел сайта, страницу или файл, который, наоборот, разрешено сканировать текущему роботу. Синтаксис: «Allow: путь к разделу/странице/файлу относительно корневой папки».

Эта запись означает, что текущий робот может сканировать только страницу visible-page.html из корневой папки, а остальные материала сайта ему недоступны.

Директива Sitemap (необязательная)

Sitemap указывает на карту сайта — файл с информацией о том, какие страницы и в каком порядке нужно сканировать. Таким образом эта директива делает индексацию сайта более эффективной. Синтаксис: «Sitemap: полная ссылка на файл карты сайты». Пример записи:

Примеры содержимого robots.txt

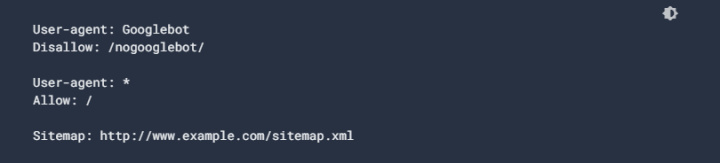

Для наглядности рассмотрим, как разные директивы записываются вместе. Ниже — примеры заполненных индексных файлов. Обратите внимание: по умолчанию поисковым роботам разрешено сканировать любые разделы, страницы и файлы, доступ к которым не заблокирован правилом Disallow.

Пример 1. Полностью запрещаем сканирование сайта для робота Google и добавляем карту сайта:

Пример 2. Полностью запрещаем сканирование сайта для роботов Google и Bing:

Пример 3. В первой группе запрещаем роботу Google сканировать все ссылки, начинающиеся с «http://site.com/nogooglebot/», во второй разрешаем полное сканирование остальным роботам:

Детальнее о синтаксисе и директивах читайте на сайтах поисковых систем.

Как создать индексный файл

Если вы пользуетесь конструктором сайтов вроде Blogger или Wix, скорее всего, вы сможете прописывать директивы прямо в настройках платформы.

Но в большинстве случаев правила нужно добавлять в отдельном файле. Вот как это сделать:

- Создайте обычный текстовый файл. Это можно сделать, к примеру, в программе Wordpad или стандартном блокноте Windows.

- Добавьте в файл необходимые директивы и сохраните его под названием «robots.txt».

- Загрузите индексный файл в директорию сайта. Как это сделать — зависит от используемого хостинга. Если не знаете, читайте инструкцию по загрузке файлов на вашу платформу.

- Проверьте доступность robots.txt на сайте. Для этого достаточно набрать адрес site.com/robots.txt, где site.com — домен вашего сайта.

Заключение

- Robots.txt — это текстовый документ, который содержит правила сканирования сайта поисковыми системами.

- С помощью этого файла можно управлять доступом поисковых ботов к любым разделам сайта, веб-страницам и даже отдельным файлам, будь то изображения, аудио или видеоролики. Таким образом можно запрещать или разрешать попадание этих материалов в результаты поиска. Поэтому robots.txt очень важен для SEO.

- Владелец сайта может в любой момент создать robots.txt, прописать необходимые правила и добавить файл на сайт. Тогда поисковики будут вынуждены соблюдать эти инструкции.

Работа с маркетинговыми и прочими интернет-сервисами предполагает множество рутинный задач: перенос лидов из рекламных каналов в CRM, отправку почтовых или SMS-рассылок, копирование данных между электронными таблицами и так далее.

Но вы можете автоматизировать эти и другие рабочие процессы с помощью нашей платформы ApiX-Drive. Достаточно подключить к ней свои рабочие сервисы и настроить передачу данных — обо всем остальном система позаботиться за вас. Попробуйте ApiX-Drive, это быстро и просто!