Три способа скрыть сайт от поиска Google

Бывают ситуации, когда нужно предотвратить попадание веб-ресурса в поиск Google либо убрать уже проиндексированный сайт из выдачи. Как это сделать — читайте в нашей статье.

Содержание:

1. Как предотвратить попадание сайта в поиск

2. Блокировка сканирования

3. Блокировка индексирования

4. Блокировка с помощью пароля

5. Как удалить уже проиндексированные страницы

6. Заключение

Как предотвратить попадание сайта в поиск

Допустим, ваш сайт еще в процессе разработки и не готов к потоку посетителей из Google. А, может быть, веб-ресурс уже доступен, но вы планируете добавить новый раздел или страницу, но пока не хотите привлекать к ним внимание аудитории. В подобных случаях можно превентивно скрыть весь сайт или его отдельные страницы от поисковой системы. Для этого есть несколько способов.

Блокировка сканирования

Google дает возможность запретить поисковому боту сканировать сайт, его разделы или даже отдельные страницы. Это может предотвратить попадание контента в выдачу.

Нужно лишь добавить несколько команд в файл с названием robots.txt, который должен присутствовать в корневой папке сайта на сервере, и сохранить изменения.

Команды, которые запретят поисковому боту Google сканировать сайт целиком:

Команды, которые запретят поисковому боту Google сканировать конкретный раздел сайта (вместо /category нужно указать путь к папке с файлами нужного раздела, исключив из него название сайта):

Команды, которые запретят поисковому боту Google сканировать конкретную страницу сайта (вместо /category/pagename нужно указать URL страницы, исключив из него название сайта):

Но очень важно понимать, что этот способ запрещает роботу только прямое сканирование. Если ссылки на ваш сайт уже есть на внешних ресурах, робот все равно может добавить его в поиск, просто без сканирования.

Поэтому, Google не рекомендует редактировать robots.txt с целью избежать попадания сайта в поисковую выдачу. Гораздо надежнее использовать способы, перечисленные ниже.

Блокировка индексирования

Вы можете не препятствовать сканированию, но при этом запретить саму индексацию страниц — то есть их добавление в выдачу. В результате робот будет проверять содержимое таких страниц, но не станет включать их ссылки в базу поиска.

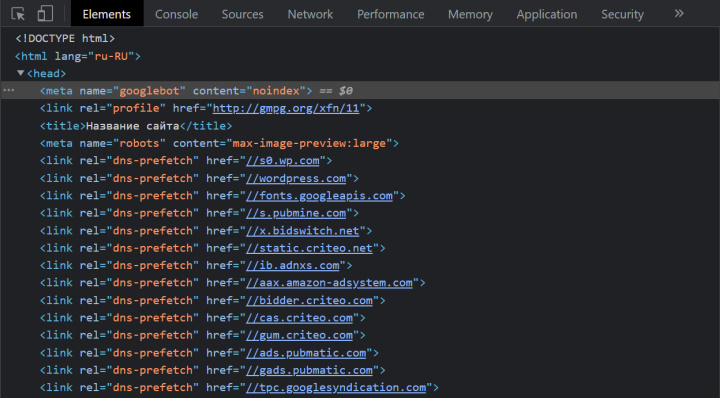

Чтобы запретить поисковому роботу Google индексацию страницы, достаточно прописать в ней метатег с директивой noindex. Для этого нужно открыть файл с кодом страницы, найти раздел head и добавить в него строчку <meta name="googlebot" content="noindex">. Если необходимо предотвратить индексацию нескольких страниц, процедуру нужно проделать с каждой из них.

К сожалению, у этого способа тоже есть недостаток. Если по какой-либо причине робот не сможет просканировать страницу, он не увидит директиву noindex и добавит эту страницу в поиск. Такое может произойти, к примеру, если в файле robots.txt будет отключена индексация.

Блокировка с помощью пароля

Самый надежный способ предотвратить попадание контента в поиск — поставить пароль на доступ ко всему сайту или же к его файлам, которые хранятся внутри конкретной папки. Эта процедура выполняется по-разному в зависимости от типа используемого сервера, хостинга и движка.

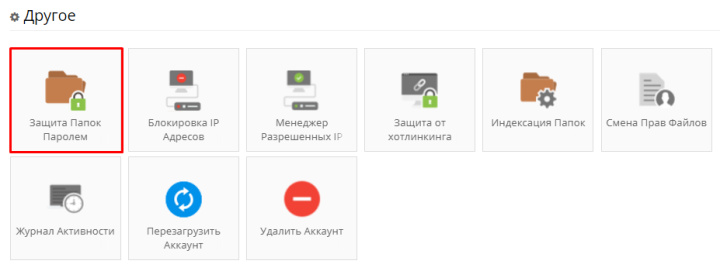

Обычно пароль можно установить с помощью панели управления сайтом, которую предоставляет хостинг-провайдер. Например, так эта опция выглядит на контрольной панели провайдера Hostinger:

Если ваш веб-ресурс работает на одном из популярных движков вроде WordPress, скорее всего, инструменты для управления паролем вы также можете найти в настройках используемой платформы или в подключаемых к ней плагинах.

Как удалить уже проиндексированные страницы

Что делать, если страницы уже попали в выдачу? В таком случае нужно

удалить их из индекса с помощью инструмента Google Search Console. Для этого выполните эти шаги:

- Перейдите по адресу https://search.google.com/search-console/removals.

- Откройте вкладку «Временные удаления».

- Нажмите «Создать запрос».

- Выберите «Временное удаление URL».

- Отправьте запрос на удаление нежелательных страниц с помощью подсказок интерфейса.

- При необходимости повторите эту процедуру с другими страницами.

Через шесть месяцев после удаления страницы робот может проиндексировать ее снова. Чтобы этого не произошло, удалите страницу с сервера или поставьте пароль на доступ к разделу, в котором она находится.

Заключение

- Есть несколько способов предотвратить попадание сайта, его раздела или отдельных страниц в поисковую выдачу: 1) заблокировать сканирование с помощью файла robots.txt; 2) заблокировать индексирование с помощью директивы noindex; 3) поставить пароль на доступ ко всему сайту или разделу.

- Последний способ — самый надежный. Чтобы данные точно не оказались в выдаче, используйте именно пароль. Инструкцию по его установке на сайт ищите в справочных материалах хостинг-провайдера.

- Страницы сайта можно скрыть от Google, даже если они уже попали в индекс. Для этого сначала нужно удалить их из поиска с помощью инструмента Google Search Console. А затем — удалить страницы с сервера или заблокировать к ним доступ через пароль.

Стремитесь вывести бизнес на новый уровень, достигать целей быстрее и эффективнее? Apix-Drive — ваш надежный помощник для этих задач. Онлайн-коннектор сервисов и приложений поможет вам автоматизировать рутинные процессы. Вы и ваши сотрудники освободите время для выполнения важных профильных задач. Попробуйте возможности Apix-Drive бесплатно, чтобы убедиться в эффективности онлайн-коннектора лично.